- 小

- 中

- 大

- 超大

只要英伟达(NVDA.O)主导人工智能芯片市场,客户就一直明确表示希望看到更多竞争。而最近的事实证明,其中一个最强有力的替代方案可能一直就在眼前。

谷歌十年前推出了其张量处理单元(TPU),旨在加速公司的网页搜索引擎并提升效率。后来,这些芯片被改造用于谷歌AI应用中的机器学习任务。

如今,谷歌正通过TPU获得重要订单,这表明它们可能成为英伟达AI加速器(用于训练和运行当今复杂大型语言模型的图形处理单元GPU)的可信替代方案。

本文将详解关于TPU的更多信息,包括其工作原理、潜力及局限性。

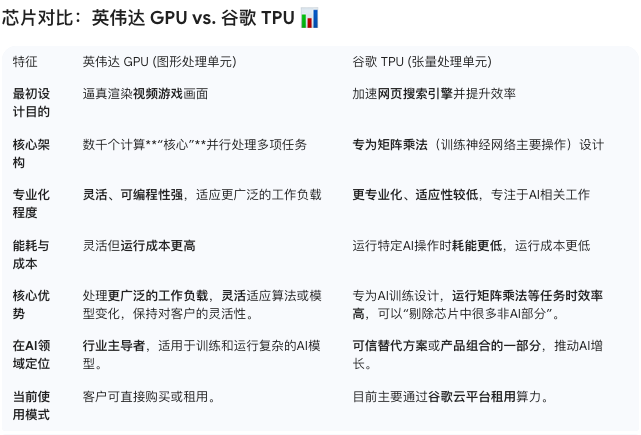

GPU和TPU有什么区别?

两种芯片都能处理训练AI模型所需的大量计算,但方式不同。

英伟达GPU最初是为逼真渲染视频游戏画面而开发,通过数千个计算“核心”并行处理多项任务。这种架构也使它们能够以竞争技术无法匹敌的速度执行AI任务。

TPU则专为一种AI相关工作,也就是矩阵乘法而设计,这是训练神经网络的主要操作,神经网络生成AI聊天机器人(如OpenAI的ChatGPT和Anthropic的Claude)对提示的响应时使用大量顺序执行的重复计算。

TPU的设计使这类任务高效完成。它们比英伟达GPU更专业化、适应性较低,但在运行这些操作时耗能更低。英伟达GPU灵活、可编程性强,但这种灵活性也意味着运行成本更高。

TPU如何成为AI场内的竞争者?

谷歌于2013年开始研发首款TPU,并于两年后发布。最初,它用于加速公司搜索引擎并提升效率。2018年,谷歌首次将TPU部署在云平台上,让客户能够使用同样技术的计算服务。

这些芯片也被改造用于支持谷歌内部AI开发。当公司及其DeepMind部门开发出如Gemini这样的前沿AI模型时,AI团队的经验被反馈给TPU设计师,从而定制芯片以更好地服务内部AI团队。

谷歌最新一代TPU名为Ironwood,于4月发布。它采用液冷设计,专用于运行AI推理工作负载(即使用AI模型而非训练模型),提供两种配置:一个包含256颗芯片的Pod,或一个更大的包含9,216颗芯片的Pod。

Seaport分析师Jay Goldberg表示,对于某些AI任务,TPU的表现可能优于GPU,因为谷歌可以“剔除芯片中很多非AI部分”。目前TPU已发展到第七代,谷歌提升了芯片性能、增强了算力,同时降低了能耗,使其运行成本更低。

谁在使用TPU?

当前TPU客户包括Safe Superintelligence,一家由OpenAI联合创始人Ilya Sutskever去年创办的初创公司,以及Salesforce、Midjourney和Anthropic等目前已经广为人知的企业。

根据10月披露的一项协议,Anthropic将通过多达100万颗TPU获得超过1吉瓦的谷歌计算能力。次月,《The Information》报道称Meta Platforms正在洽谈在2027年将谷歌TPU应用于其数据中心。

这些进展凸显了主要AI企业在追求增加算力以应对快速增长的需求时,正在积极采用TPU。

TPU销售前景如何?

最大的AI开发商在昂贵的英伟达芯片上花费数百亿美元,他们希望降低依赖并缓解供应短缺影响,这为TPU指向了巨大的潜在市场。

目前,想使用谷歌TPU的企业必须在谷歌云平台租用算力。这可能很快会改变。分析师表示,Anthropic的协议使TPU扩展到其他云平台更有可能。

目前,包括谷歌在内,没有企业打算完全取代英伟达GPU;AI发展的速度意味着这在短期内不可能。

Gartner分析师Gaurav Gupta表示,谷歌尽管拥有自己的芯片,仍是英伟达的重要客户,因为它需要保持对客户的灵活性。如果客户的算法或模型发生变化,GPU更适合处理更广泛的工作负载。

英伟达发言人表示:“英伟达领先整个行业一代。我们对谷歌取得的成功感到高兴。他们在AI领域取得了巨大进步,我们仍在为谷歌供货。”

即便是签约使用TPU的科技公司,仍在大量采用英伟达芯片。例如,Anthropic在与谷歌TPU合作几周后,就与英伟达签署了一笔大额交易。

也就是说,谷歌TPU的最佳前景可能是成为推动AI增长所需产品组合中的一部分,而非将GPU取而代之。